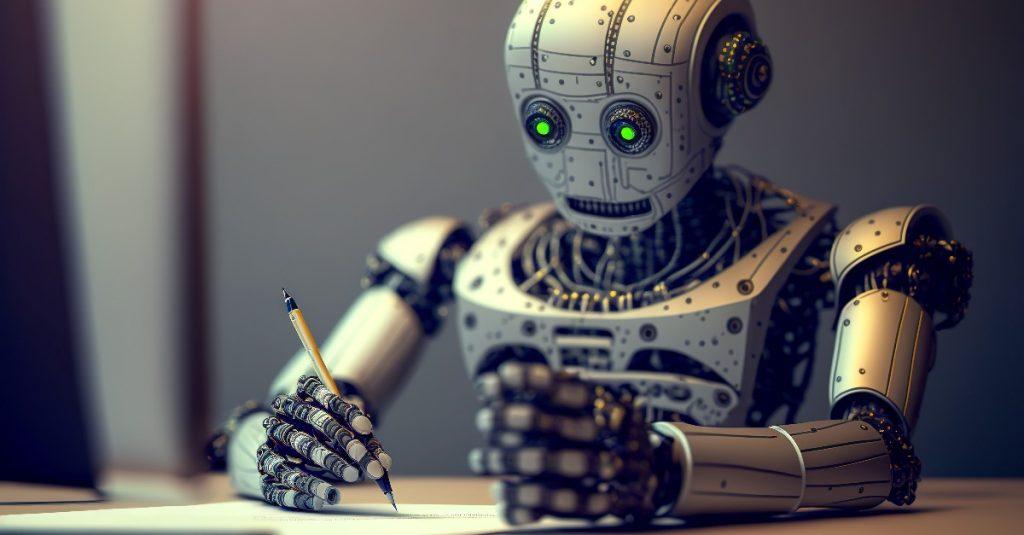

打破你的三觀 ChatGPT 可以當醫生嗎?

編譯/莊閔棻

哈佛大學電腦科學家、醫生Isaac Kohane博士與兩位同事合作,測試OpenAI的最新人工智慧模型GPT-4在醫療環境中的表現。而他們驚訝的發現,GPT-4甚至比他們觀察到的許多醫生都要好。

根據《Insider》的報導,Isaac Kohane在其新書「「The AI Revolution in Medicine: GPT-4 and Beyond」中說,2023年3月向付費用戶發布的GPT-4,90%以上的時間都能正確回答美國醫學考試的問題。它比之前的ChatGPT人工智慧模型GPT-3和-3.5要好得多,還比一些有執照的醫生好。

Kohane在書中用GPT-4做了一個臨床思維實驗,這個實驗是基於幾年前他治療的一個新生嬰兒的真實案例。當他向機器人提供了他從體檢中收集到的關於嬰兒的一些關鍵細節,以及來自超音波和賀爾蒙濃度的一些資訊時,機器正確地診斷出一種叫做先天性腎上腺增生症的罕見的疾病。Kohane寫道:「就像我有多年的研究和經驗一樣。」

Kohane既印象深刻又感到驚恐。他寫道:「一方面,我正在與一個計算過程進行複雜的醫學對話,另一方面,同樣令人震驚的是,我焦慮地意識到,數以百萬計的家庭將很快可以獲得這種令人印象深刻的醫學專業知識,而我無法想出我們如何能夠保證或證明GPT-4的建議將是安全或有效的。」

GPT-4並不總是可靠的,在書中,Kohane也提到了許多其失誤的例子,範圍從簡單的文書錯誤,如誤報機器人剛才正確計算的BMI,到數學錯誤,如不準確的解決一個數學問題,或忘記在一個方程式中平方一個項目等。雖然這些錯誤都很小,但系統有一種傾向,即使受到挑戰,它也會斷言自己是正確的。因此,不難想像,一個放錯位置的數字或計算錯誤就可能會導致處方或診斷的嚴重錯誤。

當本書作者問及這個問題時,GPT-4說:「我無意欺騙或誤導任何人,但我有時會根據不完整或不準確的數據做出錯誤或假設。(但)我也沒有人類醫生或護士的臨床判斷或道德責任。」

總的來說,雖然人工智慧確實很強大,但對於專業知識,目前我們可能還是需要透過專業人士的鑑定,才能知道機器人給的答案是否有誤。若是一昧的相信,也很有可能會造成重大傷害。

參考資料:Insider

瀏覽 25,348 次