向Nvidia 下戰帖!Google展示新AI 超級電腦

編譯/莊閔棻

日前,科技公司Alphabet旗下的Google公布了,其用於訓練人工智慧模型超級電腦的新細節,並稱這些系統比輝達(Nvidia )的同類系統更快更省電。

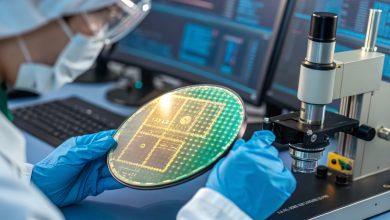

根據路透社的報導,早在2015年,Google就在使用自己開發的、專門用於加速機器學習的專用積體電路「張量處理器」(Tensor Processing Unit、TPU),用於該公司 90%以上的AI訓練工作,並於 2018 年將 TPU 提供給第三方使用。而現在,Google表示,為了運行和訓練人工智慧模型,他們已經建立了一個系統,將超過4,000個Google 張量處理器(TPU)串聯起來。

改善TPU之間的連接已經成為建造人工智慧超級電腦公司之間競爭的一個關鍵點。隨著Google的Bard或OpenAI的ChatGPT等大型語言模型規模的爆炸性增長,它們已經遠遠無法儲存在單個晶片上。

也就是說,這些模型必須被分割到數以千計的晶片中,然後這些晶片必須共同工作數週或更長時間來訓練模型。迄今為止,Google公開的最大的語言模型PaLM,就是透過分成兩個各由4,000個晶片組成的超級電腦,歷時50天進行訓練的。Google表示,其超級電腦可以很容易地在運行中重新配置晶片之間的連接,並能避免發生問題和調整並提高性能。

Google指出,比起同等規模的系統,其晶片比基於Nvidia A100晶片的系統快1.7倍,省電1.9倍。A100與第四代TPU同時上市。Google表示,他們之所以沒有將其第四代產品與Nvidia目前的旗艦產品H100晶片進行比較,是因為H100是在Google的晶片之後上市的,而且是用更新的技術製造的。

不過,Google也暗示,為了與Nvidia H100競爭,他們似乎正在開發一種新的TPU,但沒有提供細節。Google研究員Norm Jouppi表示,Google有 「一個健康的未來晶片管道」。

參考資料:Reuters

瀏覽 1,415 次