防止Azure AI產出有害內容 微軟推安全工具

記者/竹二

AI相關技術逐漸普及與進步的同時,相關資安隱憂也揮之不去。為了防止Azure AI服務與模型遭輸入惡意指令產出有害內容,甚至是洩露個資,微軟近日宣布提供多項安全工具,協助生成式AI應用開發單位偵測及防範提示注入攻擊、AI幻覺、AI模型濫用等問題,目前已經提供部份功能測試。

生成式AI應用伴隨風險

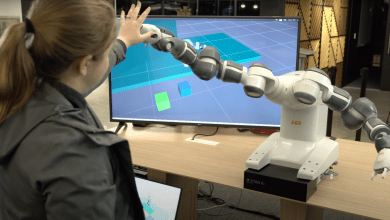

生成式AI伴隨著相關風險,像是提示注入(prompt injection)攻擊,或是濫用AI系統漏洞等,讓AI聊天機器人做出規範以外的行為,微軟為此公布一系列新工具,包含提示防護罩(Prompt Shields)、AI模型幻覺偵測、系統範本、越獄評估工具,以及風險與安全監控工具等,將推向Azure AI Studio提供給開發商開發生成式AI App。

更多新聞:資料安全隱患 美眾議院內部禁用微軟Copilot

提示防護罩部分,可以即時偵測並阻斷基礎模型接收到惡意提示,這是基於去年11月微軟推出的越獄風險偵測所做的擴充。根據微軟的說法,提示注入包含直接的越獄及間接攻擊,最新工具強化輸入提示的偵測,防範對象由原本的直接攻擊再加入間接攻擊,預計這項功能不久後就會整合到Azure AI Content Studio當中。

可協助偵測不真實內容

除此之外,微軟還有其他改善生成式AI服務安全性的工具,像是真實性(Groundedness)偵測工具,可以偵測文字結果的「不真實內容」,防範AI模型幻覺問題,微軟即將在Azure AI Studio及Azure OpenAI Service加入安全的系統訊息範本,讓開發人員能建立安全的系統訊息,導引模型使用訓練資料與正確的行為。

Azure AI Studio除了預建的模型品質評估工具,微軟還將再新增自動化越獄評估工具,原本的量測工具只會判斷真實性、相關性和流暢度等指標,新工具可偵測AI應用被越獄攻擊、產出暴力、自殘、色情、仇恨、歧視等內容的可能性,也會以自然語言解釋評估結果。微軟指出,這些工具都將在不久後整合到Azure OpenAI Service及Azure AI Studio中。

瀏覽 531 次