生成式人工智慧在工作上會帶來什麼風險?|專家論點【Howie Su】

作者:Howie Su(產業分析師)

看似清晰卻又缺乏證據佐證的科技風險

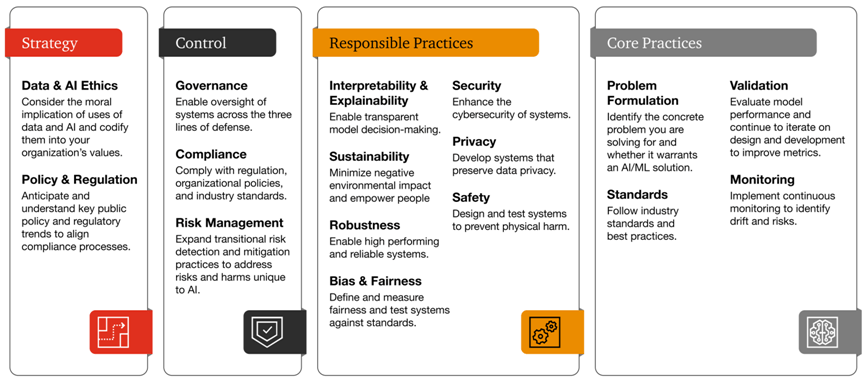

隨著生成式人工智慧的指數級增長,迫切需要評估這些解決方案在工作場所的法律、道德和安全影響。行業專家強調的擔憂之一往往是許多生成式人工智慧模型訓練的數據缺乏透明度。關於用於 GPT-4 等模型的訓練數據的細節資訊的不足,GPT-4 為 ChatGPT 等應用程式提供相當便利性,但這種缺乏透明度的情況延伸到演算法與個人用戶互動過程中獲得的資訊並加以儲存,進一步增加法律與合規風險:透過與生成式人工智慧解決方案的互動而洩露公司敏感數據或機密的可能性值得高度關注,即便ChatGPT 背後的組織 OpenAI 在提供有關如何處理用戶數據的詳細信息方面一直非常謹慎,但事實上是許多企業並未針對這種風險制訂有效政策,而是放任員工持續使用這類工具,而更值得注意的是,雖然沒有具體證據表明提交給 ChatGPT 或任何其他生成人工智慧的數據可能會被儲存並與其他人共享,但資安風險仍然存在,這是使用者必須關注的挑戰。

人工智慧應用本身的安全性可能較差

將任何新應用程式整合到網路中都會產生新的漏洞,這些漏洞可被利用來訪問網路中的其他區域。生成式人工智慧應用程式會帶來獨特的風險,因為它們包含複雜的算法,使開發人員很難識別安全漏洞,人工智慧還不夠聰明,無法理解軟體開發的複雜細微差別,這使得其代碼容易受到攻擊。評估 GitHub Copilot 生成的代碼安全性的研究發現,近 40% 的人工智慧建議容易導致代碼漏洞。如果人工智慧模型可以被欺騙,那麼使用該人工智能開發的應用程式就能夠執行惡意軟體,甚至繞過安全控制,造成更大危害;同時,缺乏人類監督的人工智慧模型可能容易受到資料誤導的影響,如果使用人工智慧的聊天機器人被要求提供當地餐廳的菜單,但模型缺乏在哪裡下載安全的網路瀏覽器,或者使用安全的 VPN,則使用者可能會被引導至包含勒索軟體的冒名網站而渾然不知。

駭客的攻擊能力也可能獲得等比級數提升

駭客能夠使用生成式人工智慧工具來提高自身的攻擊能力,舉例而言,網路安全公司 HYAS Labs 發現「BlackMamba」,一種人工智慧惡意軟體,該軟體每次執行時都可以自動更改自己的代碼,從而繞過資安軟體的端點檢測,使攻擊更加有效。駭客還使用生成式人工智慧來提高網路釣魚攻擊的複雜性,他們可以透過建立互聯網(包括社交媒體和其他公共資訊源)的應用程式來啟動更精密的網路釣魚目標檔案,從而使這些詐騙訊息更加客製化,它也能大規模收集個人資訊,生成式人工智慧工具可以幫助駭客快速建造更真實的欺騙網站,誘使他人分享個人資訊,進一步他們擴展大量的欺騙網站,每個網站與其他假冒網站只有很小的區別,從而提升繞過網路安全工具的機率,使得大規模的網路釣魚行動成為可能。諷刺的是,使用者正在將人工智慧嵌入到瀏覽器、電子郵件與文檔管理系統中,賦予人工智慧自主權,讓這些虛擬助手做事,結果無形中與其分享個人和公司資訊,造成一批新的資安危機。

瀏覽 928 次