國際關係下白宮的兩難:AI發展跟監管能找到甜蜜點嗎?|專家論點【Howie Su】

作者:Howie Su(產業分析師)

美國政府今年五月再祭出AI緊箍咒

2023年5月4日,拜登政府公佈了針對人工智慧管制的最新規範,目的在「保護人權與安全」,這種做法雖然已經屢見不鮮,但對某些人來說可不一定是好事,Google、Meta、微軟這些巨頭原先在數位世界自由翱翔,現在突然發現從歐盟到日本,甚至美國自家政府都開始立起緊箍咒,企業投入法規遊說的效益越來越低,先不談歐盟從2018年的GDPR後針對數位產品跟AI監管的規定越來越多,原先幫這些科技業講話的川普下台後,拜登倒是蠻積極的在限制AI發展,各種規範框架跟監測機制推地好不熱鬧,加上現在資料都得留在地主國以免流入敵對國家手中,先不要說訓練與應用,當資料都掛上「可能危害國安」時,人工智慧模型能吃的資料源勢必大幅減少。問題是,現在的幾個大國又在拼數位成長,卡在中間的科技業就頗為尷尬。拜登政府的新規這次講了什麼?主要有三項。

1. 大幅投入美國AI技術研發投資

2. 現有的生成式AI系統需經公共審核

3. 政府制定AI政策前需要先辨識風險與機會

當AI模型從「私有財」轉為「半公共財」時

整體來說的變化是什麼?過去美國政府重心著重在框架(大方向)制定,企業把這些框架放入自己的策略中,基本上就較無疑慮,現在時代不同了,框架有了以後,各種規範跟細則慢慢出台。有趣的是,這些AI模型因為會被社會使用,所以開始從企業擁有的「私有財」逐漸轉變為「半公共財」,這在模型評估的流程就相當重要了,過去企業可能使用的數據多數來自內部,外部可能使用的是不牽涉到個人隱私的公開數據,但現在的模型,例如大型語言模型,裡面的資了很難分辨是否有牽涉到人隱私的資料,由於模型評估對於確保 AI 模型是否準確、可靠且零偏差至關重要,這對於在實際應用中成功部署至關重要。以城市規劃用例,若沒有正確的評估方式,那生成式AI在評估城市公共建設的地區時可能帶有歧見,或是金融機構的放貸可能讓有錢人(信用可能較好)貸到更多資金,而貧窮人反而無法獲取金融服務,更甚者,當前流行的AI面試讓很多人怎麼被刷掉的都不知道,這種企業基於營業秘密的「不可解釋性」算不算是一種歧視?

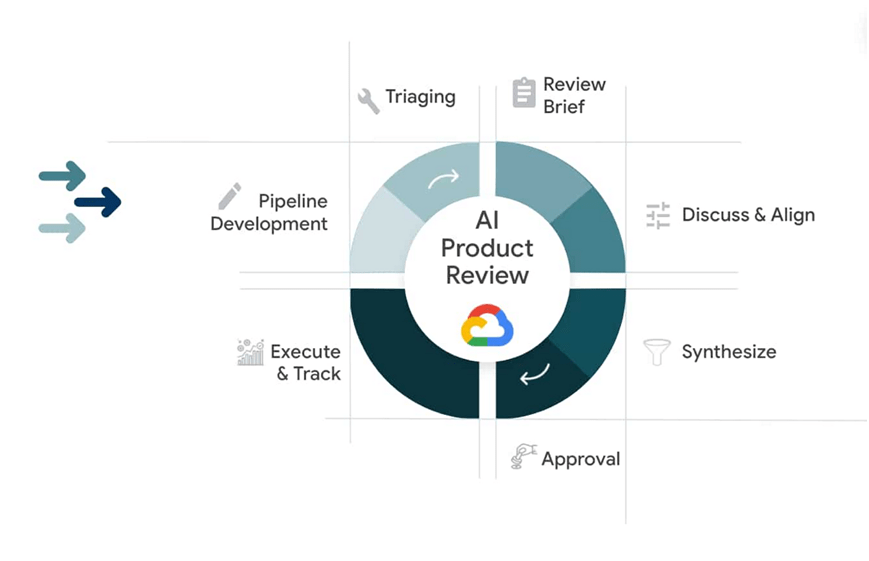

加速數位服務的兩極化是AI帶來的嚴重問題,這也是為何拜登政府這麼注重評估模型公正性的人選不應該只有企業本身。因此,為降低AI的偏見,拜登政府宣佈在「DEFCON 31 AI Village」上進行模型評估,DEFCON 31 AI Village是一個能讓研究人員與技術愛好者聚集在一起探索AI和機器學習最新進展的平台,模型評估是一項與該領域的主要企業參合作的計劃,包括 Anthropic、Google、Hugging Face、微軟、Nvidia、OpenAI 和 Stability AI等。在生成式 AI 系統變得更加強大和廣泛時,所有利益相關者,例如新創創辦人、資通訊業者、投資人、技術專家、消費者、監管機構等,都必須深思熟慮並有效率地追求和參與這些模型的評估,盡可能避免造成各種歧視,透過這種DEFCON 31 AI Village公開平台,把這種半公共財變成真的能解決問題的工具,而非打造更多資訊黑盒子的幫凶,接下來的兩年,我們要知道的是,「AI怎麼用」是技術使用者與開發者的問題,但「AI怎麼管」是全社會,甚至是在職人士的問題。

瀏覽 1,007 次