史丹佛AI指數報告有什麼亮點?|專家論點【Abby Lin】

作者:Abby Lin(科技業產業研究員)

近來,史丹佛大學發布第七份人工智慧指數報告,內容涵蓋人工智慧技演進與社會大眾對該技術的看法等趨勢,這次重點在於,人工智慧對社會的影響從未如此明顯,自2022年底ChatGPT提供強大的人機協作以來,生成式AI和大型語言模型(LLM)的快速開發/部署已開始改變產業,並顯示出改變現代生活的潛力,人工智慧在多項工作上的表現甚至超越人類水平,並成功地協助員工提高生產力並提供更高品質的工作,以下先提出五大亮點供讀者參考。

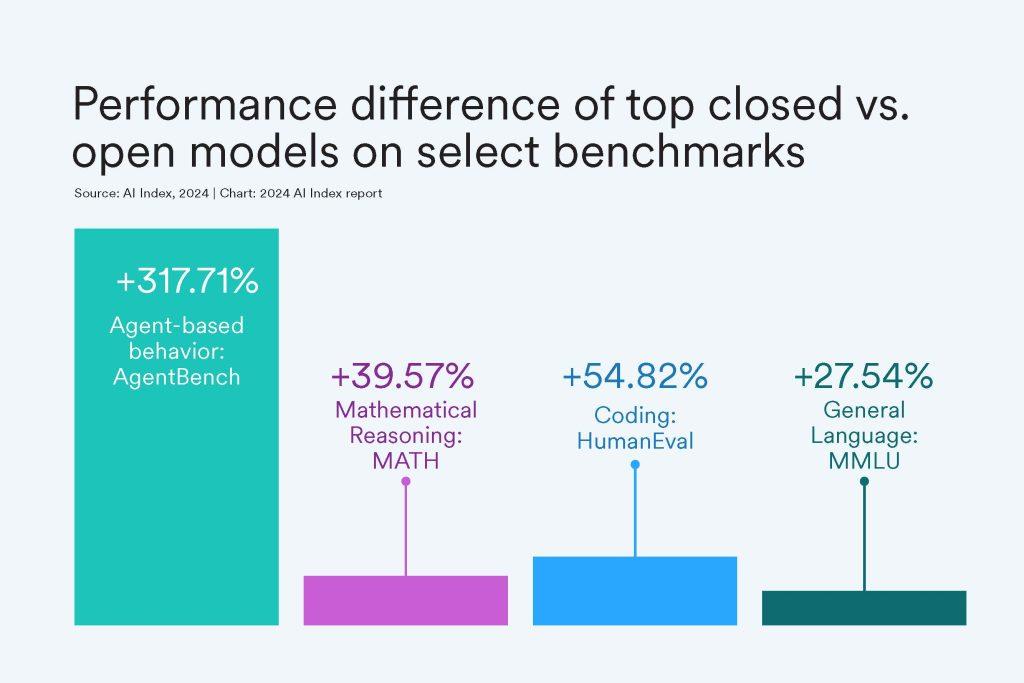

一、人工智慧表現可望超越人類

截至2023年,人工智慧的表現或將超越人類,包括圖像分類、視覺推理和英語理解,然而,人工智慧仍然在某些任務類別上無法超越人類的能力,尤其是複雜的認知任務,這些任務包括視覺常識推理和規劃以及數學競賽等。

二、產業、而非學術界,將引領AI發展

直到2014年,學術界主導了機器學習模型的發表。現在情況已不再是這樣了。 2023年,工業界產生了51個機器學習模型,而學術界只有15個。有趣的是,2023年產學合作共誕生了21個著名模型,創下新高,產業顯著提升的背後是什麼?主因在於建立尖端的人工智慧模型現在需要大量的數據、運算能力和財務資源,而這些在學術界通常是無法獲得的。

三、模型成本高昂

如前所述,法學碩士的運作或培訓費用並不便宜。根據AI Index測算,領先AI模型的訓練成本大幅增加。例如,OpenAI 的GPT-4培訓成本估計為7,800萬美元,而Google的Gemini Ultra成本為1.91億美元,相較之下,早在2017年,最初的 Transformer 模型被認為引入了支撐幾乎所有現代法學碩士的架構,其訓練成本約為900美元。

四、缺乏負責任人工智慧的標準

人工智慧工具基準的有效性很大程度上取決於其標準化方法和應用,然而,人工智慧指數的研究表明,負責任的人工智慧報告嚴重缺乏標準化。例如,包括OpenAI、Google 和Anthropic在內的領先開發人員主要根據不同的負責任的AI基準測試他們的模型,這可能對使用者造成不同程度的負面影響。

五、創造更高品質的工作

雖然在沒有適當監督的情況下使用人工智慧可能會導致績效下降,但幾項評估人工智慧對勞動力影響的研究表明,它使員工能夠更快地完成任務並提高其產出品質,研究也顯示人工智慧有潛力彌合低技能工人和高技能工人之間的技能差距。

六、人工智慧在對科學進步幾色吃重

AI Index表示,雖然2022年人工智慧開始推動科學發現,但2023年在科學相關人工智慧應用程式發布方面將進一步飛躍,例子包括Synbot,一個由人工智慧驅動的機器人化學家,用於合成有機分子,以及GNoME,它為機器人和半導體製造等領域發現穩定的晶體。

七、人們更擔心人工智慧的影響

該調查顯示,在過去一年中,認為人工智慧將在未來三到五年內極大影響他們生活的人比例從60%增加到66%,對人工智慧產品和服務的不安情緒比2022年上升了13個百分點,據報道有55%的人感到緊張。該報告還引用了皮尤研究中心的數據,該數據表明,52%的美國人對人工智慧的擔憂多於興奮,高於 2022年的38%。

瀏覽 526 次