Phi-2是什麼?微軟新創舉 最強小型語言模型

編譯/黃竣凱

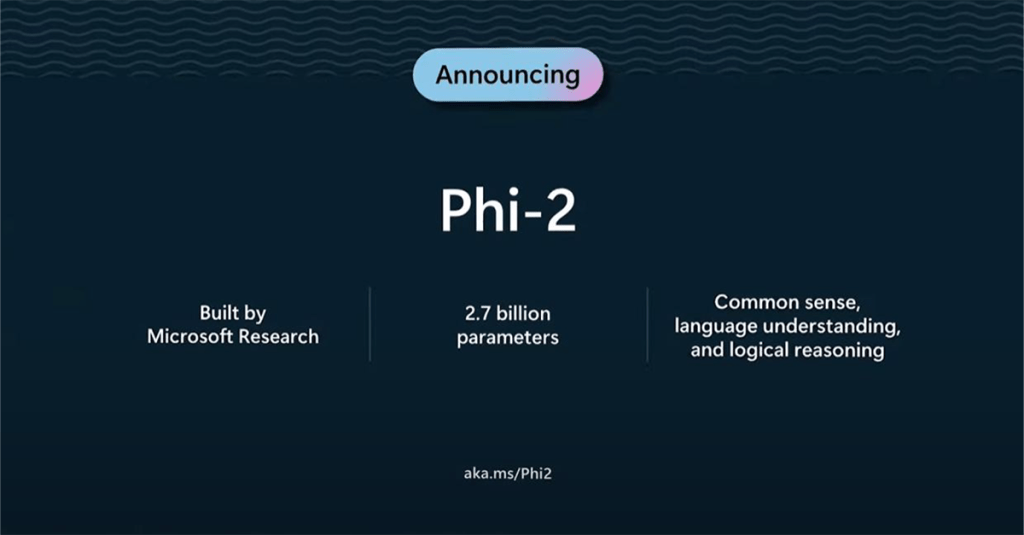

微軟剛發布新小型語言模型Phi-2。雖然與GPT-4、Bard等大型語言模型(LLM)相比,它相對較小,只有27億個參數,但該模型可以說是非常強大。微軟聲稱, Phi-2 已可以在各種生成式 AI 基準測試中超越 Llama-2、Mistral 和 Gemini-2 等更大的模型。Phi-2是Phi-1.5的升級版本,目前已可透過 Azure AI Studio 使用。以下我們就將帶大家來了解這個微軟的新創舉。

多種能力

微軟指出,在特定任務上,Phi-2 甚至可以超越 25 倍大的模型。Phi-2 最初由微軟執行長 Satya Nadella 在 Ignite 2023 上宣布,並於不久前發布。該模型由微軟研究團隊構建,並具有「常識」、「語言理解」和「邏輯推理」等能力。

更多新聞:未來學專家警告:不要讓AI蒙蔽雙眼

更具成本效益

Phi-2使用「教科書等級」的資料進行訓練,其中包括合成資料集、常識、心理理論、日常活動等。它是一個基於transformer的模型,具有下一個單字預測目標等功能。不只如此,與 GPT-4 相比,在特定資料上訓練該模型,不但更容易還更具成本效益。微軟在 96 個 A100 GPU 上對 Phi-2 進行了 14 天的訓練,而根據報告,GPT-4 的訓練時間約為 90-100 天,使用了數萬個 A100 Tensor Core GPU。

優於多種大型模型

此外,微軟的 Phi-2 還可以解決複雜的數學方程式和物理問題,並能識別學生在計算中犯的錯誤。而在常識推理、語言理解、數學和編寫程式碼等基準測試中,Phi-2 的表現不但優於 13B Llama-2 和 7B Mistral,還比 70B Llama-2 大型語言模型更好,性能甚至超過擁有 3.25億參數 的 Google Gemini Nano 2。

小模型、大優勢

事實上,基於可以在功耗和計算要求較低的情況下運行,並使用較低的成本,性能優於 Llama-2 等大型語言模型,較小模型具有巨大優勢。這些模型不但可以針對特定任務進行訓練,還可以輕鬆地在設備上運行,進而減少輸出延遲。

參考資料:Indian Express

瀏覽 2,704 次