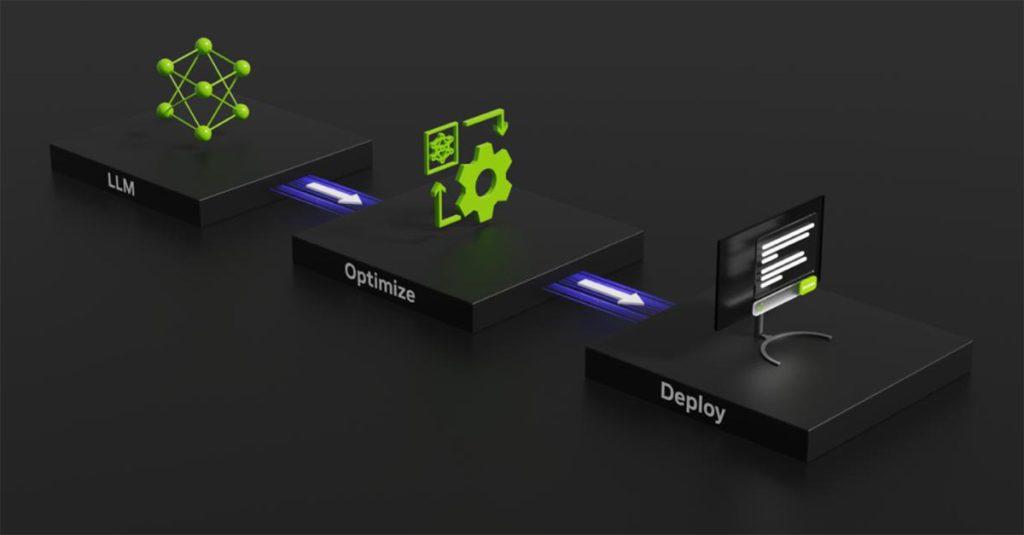

NVIDIA TensorRT-LLM新軟體 助攻大型語言模型推論性能

記者/Shirley

NVIDIA公布TensorRT-LLM軟體將在未來幾週內發布,可與NVIDIA H100 GPU配合使用,將加快大型語言模型的推論速度及取得最佳的推論結果,推論性能提升兩倍,以擴大人工智慧潛在的應用領域。

未來幾週內發布

NVIDIA表示,不斷與 Meta、AnyScale、Cohere、Deci、Grammarly、Mistral AI、MosaicML(現已成為 Databricks 的一員)、OctoML、Tabnine及Together AI等企業密切合作,以加快大型語言模型的推論速度及取得最佳的推論結果。這些創新項目已經整合進開源型態的 NVIDIA TensorRT-LLM 軟體,將在未來幾週內發布。

已開放早期試用

NVIDIA TensorRT-LLM 目前已開放早期試用,不久將整合進企業級人工智慧軟體平台NVIDIA AI Enterprise中的NeMo框架,開發人員與研究人員可以透過 NGC 上的 NeMo 框架或 GitHub 上的源碼庫取得 TensorRT-LLM。

更多新聞:Google Cloud與NVIDIA合作 助攻生成式人工智慧發展

可快速自訂功能

TensorRT-LLM 由 TensorRT 深度學習編譯器組成,包括經最佳化調整的內核、前處理和後處理步驟,以及多GPU/多節點通訊基元,可在 NVIDIA GPU 上創造出突破性的效能表現。讓開發人員能夠嘗試新的大型語言模型,提供峰值效能和快速自訂功能,而無需具備深厚的 C++ 或 NVIDIA CUDA 相關知識。且透過開源模組 Python API,提高了易用性和擴充性,可用於定義、最佳化和執行新架構,還會隨著大型語言模型的發展而增強,且能輕鬆自訂相關內容。

大規模進行推論

TensorRT-LLM 使用一種模型平行化(model parallelism)的 tensor 平行,將個別權重矩陣分割到各個裝置上,透過 NVLink 連接的多個 GPU 和多個伺服器上平行運作每個模型,無需開發人員出手干預或修改模型,就能以大規模高效率的方式進行推論,開發人員可以利用 TensorRT-LLM 中開源型態的最新 NVIDIA 人工智慧內核,將其模型調整至最佳狀態。

瀏覽 721 次