Meta發表圖像生成模型CM3Leon 用文字就能產生各種圖片

記者/竹二

生成式AI應用越來越廣,Meta近日發表了可同時支援文字與圖像生成的CM3Leon模型,這是第一個由純文字語言模型配方,所訓練出來的多模態模型,Meta表示,其圖像生成所使用的訓練運算資源,只要其他方法的1/5,就可達到先進效能。

所謂的CM3Leon,是一個基於Token、檢索增強與decoder-only的模型,採用「因果隱蔽混合模態」架構,代表著該模型可以只關注之前的元素來生成輸出序列,確保生成內容的連貫性,訓練過程中還能夠忽視或隱蔽某些元件,以生成出更好的結果,並同時處理文字及圖像的輸入。

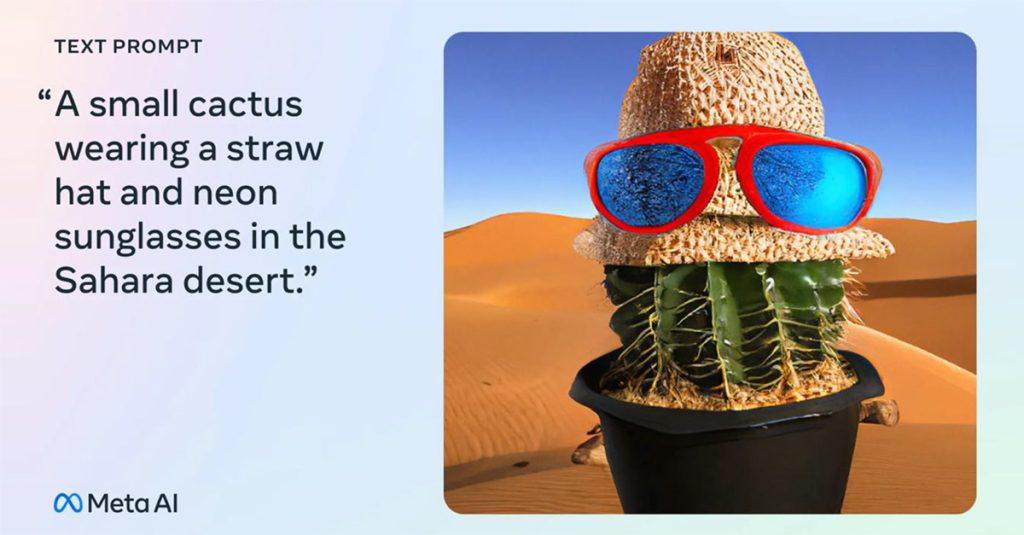

Meta強調,CM3Leon是通用模型,透過單一模型就可處理許多不同的任務,像是以文字描述來生成圖像,也能以文字描述來編輯圖像,或是要求模型替圖像生成圖說等功能。Meta舉例,可用文字要求生成「在沙漠的一株小仙人掌,戴上一頂鑲有霓虹太陽眼鏡的草帽」的圖像,也能利用文字幫《戴珍珠耳環的少女》戴上墨鏡等。

相關研究人員指出,CM3Leon只使用30億個Token的文字資料進行訓練,大幅低於OpenFlamingo的400億個與Flamingo的1000億個Token,卻能在替圖像產生圖說並回答圖像問題等2個任務上,達到相當的zero-shot效能等級,在回答VizWiz資料集中圖像問題的表現,甚至還勝過Flamingo。

有別於今年5月的ImageBind大方開源整合文字、聲音與視覺資料的多模態AI,這一次Meta並未公布是否或何時釋出CM3Leon。

瀏覽 2,524 次