AI解碼大腦活動 翻譯植物人心聲

躺在病床上的植物人,看似毫無反應、無法表達,但是我們真的對其內心世界一無所知;現在,透過全新的AI人工智慧技術,以「非侵入」方式進行實驗,利用每位參與者3秒鐘的大腦活動數據來解碼他們聽到的內容,目前證明準確率可達73%。

雖然這實驗目前僅是解碼「語音感知」,而不是「語音生成」,但已經向前跨了一大步,未來將有機會應用於全球數以萬計無法通過語音、打字或者手勢進行交流的人群,其中包括:最低限度的意識狀態、閉鎖綜合症或者植物人狀態患者,現在他們通常被稱為「無反應清醒綜合症人群」。

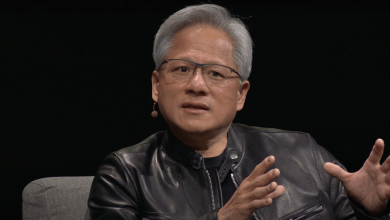

目前大多數幫助語言表達障礙人群的解決方案,是進行高風險腦部手術植入電極;而Meta公司AI研究員、神經科學家珍妮-雷米·金(Jean-Remi King)則嘗試用非侵入性方法。珍妮和同事研發了一種語言模型,可以檢測53種語言的56000小時語音錄音中的單詞和句子。

研究團隊將帶有語言模型的人工智能系統應用於4個機構的數據庫,其中包括169名志願者的大腦活動;在這些數據庫中,參與者傾聽不同的故事和句子,工作人員使用腦磁波描記器(MEG)或者腦電圖儀對參與者的大腦進行掃描,這些設備可以測量大腦信號的磁成分或者電成分。

實驗發現使用腦磁波描記器進行測試,參與者選擇答案的準確率達到73%;但是,腦磁波描記器是一部笨重且成本昂貴的機器,因此這項技術仍需創新改良,從而使該設備成本更低、更易於使用。(記者/白水堯)

瀏覽 1,027 次