鴻海研究院推首款繁體中文AI大型語言模型 未來將對外開源

記者彭夢竺/台北報導

鴻海研究院(HHRI)今(10)日宣布,推出首款繁體中文AI大型語言模型(LLM),內部開發代碼FoxBrain。根據鴻海的說法,該模型在四個星期內完成訓練,原為內部應用而設計,涵蓋數據分析、決策輔助、文書協作、數學、推理解題與代碼生成等功能,後續將對外開源分享。

FoxBrain的開發過程

FoxBrain作為鴻海研究院AI推理LLM模型訓練成果,展現了強大的理解與推理能力,還能針對台灣使用者的語言風格進行優化,並在數學與邏輯推理測試中表現出色。鴻海研究院人工智慧研究所所長栗永徽表示,近幾個月,推理能力的深化以及GPU的高效運用逐漸成為AI領域發展主流,FoxBrain模型採用高效訓練策略,專注於訓練過程優化而非盲目堆砌算力,通過精心設計的訓練方法和資源優化,成功打造出具備強大推理能力的本土AI模型。

延伸閱讀:騰訊AI聊天機器人「元寶」打敗DeepSeek 奪下載量排行榜冠軍

鴻海研究院人工智慧研究所在FoxBrain訓練過程中,使用120張NVIDIA H100 GPU,並透過NVIDIA Quantum-2 InfiniBand網路進行擴展,只花約四個星期的時間完成,相較於近期其他公司所推出的推理模型,以更高效率,更低成本的模型訓練方式為台灣AI技術發展樹立新里程碑。

FoxBrain的技術亮點

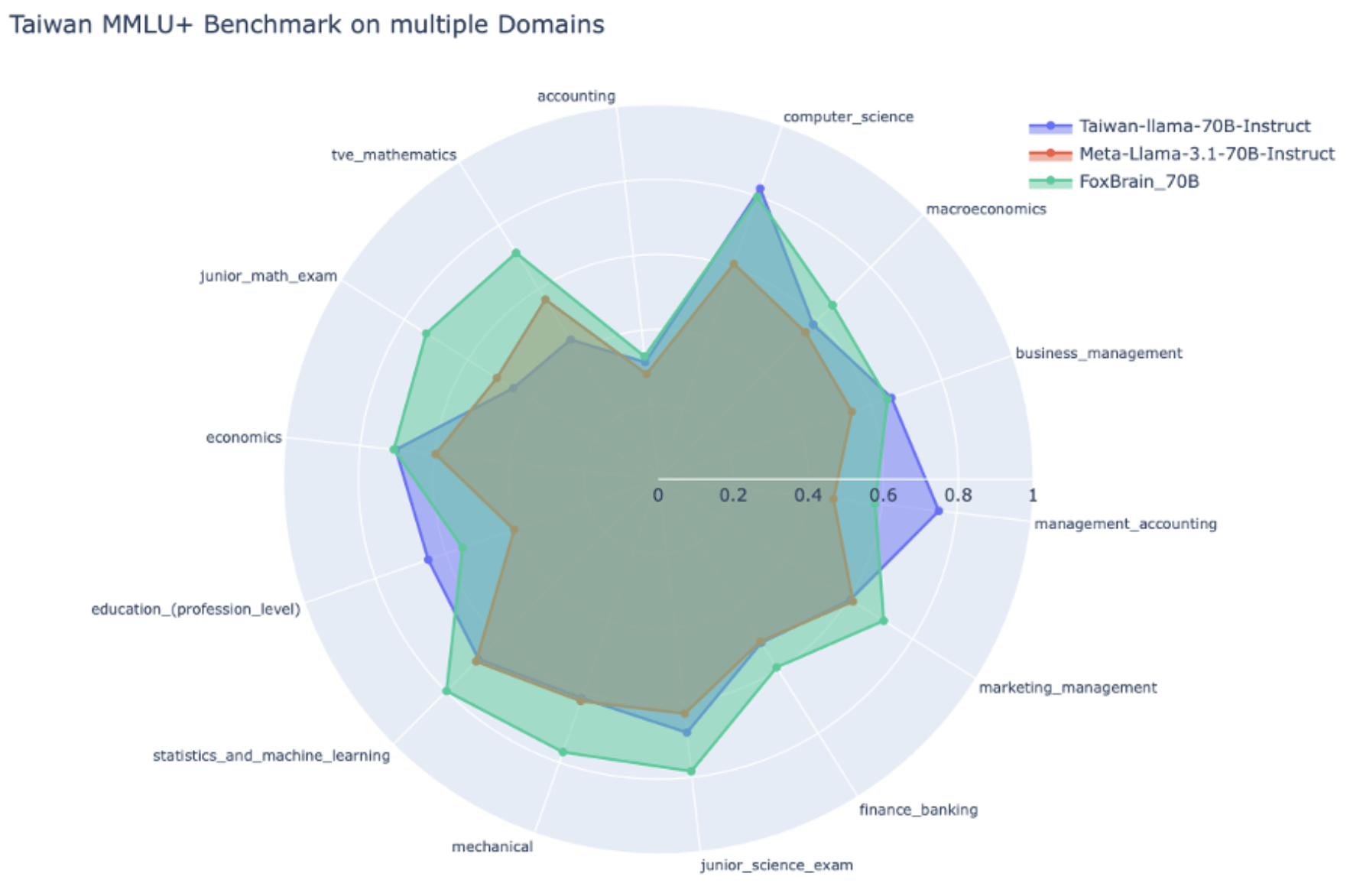

FoxBrain採用Meta Llama 3.1為基礎架構,擁有70B參數,在TMMLU+測試資料集,大多數的領域優於相同規模的Llama-3-Taiwan-70B,尤其在數學與邏輯推理方面展現卓越能力。

FoxBrain透過自主技術,建立24類主題的資料增強方式與品質評估方法,生成98B tokens高品質中文預訓練資料,上下文處理長度約128 K token,總計算力花費2688 GPU days,採用多節點平行訓練架構,確保高效能與穩定性,並使用獨特的Adaptive Reasoning Reflection技術訓練模型學會自主推理。

在測試結果方面,FoxBrain在數學領域較基礎模型Meta Llama 3.1全面提升,相較於目前最好的繁體中文大模型Taiwan Llama在數學測試中取得顯著進步,並在數學推理能力上超越Meta目前已推出的同等級模型,雖然與DeepSeek的蒸餾模型還是有些微差距,但表現已相當接近世界領先水準。

台灣AI技術競爭力

鴻海研究院指出,FoxBrain的研發從資料收集、資料清理與擴增、Continual Pre-Training、Supervised Finetuning、RLAIF、Adaptive Reasoning Reflection,以自主研發的方式一步一腳印,穩紮穩打把每一個環節做好,最終在運用有限的算力資源下,仍能達到接近世界頂尖AI大模型的效益。

此大型語言模型的研究成果,顯示台灣科技人才在AI大模型領域也能夠與國外人才並駕齊驅。FoxBrain模型雖然起源於鴻海研究院為集團內部應用而設計,未來將持續與技術夥伴合作,對外開源分享,擴大FoxBrain模型運用範圍,共同推動AI在製造業、供應鏈管理與智慧決策領域的應用。

瀏覽 1,528 次