和碩2024OCP全球峰會將推6款全新AI、LLM伺服器

記者/孫敬 Archer Sun

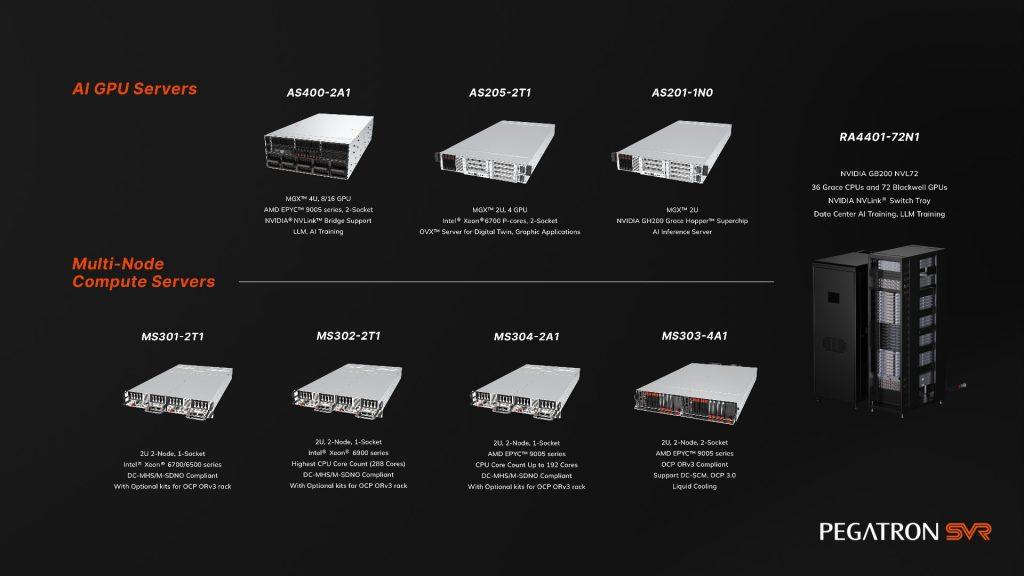

電子系統與設備開發商和碩聯合科技,宣布將在2024 OCP(開放運算計畫全球峰會)展示最新AI解決方案,包含6款AI、LLM伺服器。和碩伺服器解決方案支援ORv3機架標準,符合DC-MHS規範,並提供19吋至21吋OCPv3機架伺服器套件,以及液冷和風冷等多種自訂功能。

延伸閱讀:蘋果iPhone 16銷售放緩?和碩童子賢:短期波動無需過度擔憂

雙節點、AI及LLM訓練伺服器為本次展出亮點

和碩即將在2024 OCP展出的亮點產品,聚焦在2款2U雙節點單/雙插槽處理器解決方案,4款專為訓練AI和LLM伺服器。

「2U 雙節點,AMD EPYCTM 9005雙插槽處理器伺服器解決方案(MS303-4A1)」

符合OCP ORv3標準的液冷伺服器,配備ORv3 Busbar以提供48VDC 電源。每節點提供2個E1.S埠、8個 NVMe SSD(E3.S)、2個PCIe 5.0 LP插槽、4 個OCP 3.0插槽。MS303-4A1擁有更靈活的擴展插槽和SSD配置,適合雲端運算等應用場景。

「2U雙節點,Intel® Xeon® 6單插槽處理器伺服器解決方案(MS301-2T1和MS302-2T1)」

MS301-2T1和 MS302-2T1為多功能伺服器,適合高效能計算、遊戲及存儲等應用,支援EIA-19吋到21吋ORv3機架升級,且符合DC-MHS規範,適應現代數據中心的多變需求。

「大型語言模型訓練與推理伺服器機櫃(RA4401-72N1)」

RA4401-72N1基於輝達GB200 NVL72系統架構設計,最多可部署72個NVIDIA Blackwell GPU與36個NVIDIA Grace CPU,以提供超高運算效能、液冷架構,專為大型語言模型訓練與推理工作負載而設計。

此伺服器搭載 NVIDIA BlueField-3 DPU,實現雲網絡加速及強化安全性,並採用Axiado BMC模組方案,提供更安全的節點管理。

除了上述三款重點產品外,另外三款:4U 8x GPU伺服器(AS400-2A1),適合用作AI 訓練、大型語言模型及高效能計算;2U 4x GPU伺服器(AS205-2T1)專為 AI、圖形處理和數位孿生應用設計;2U AI 推理 / 訓練伺服器(AS207-2N1)適合數據密集型任務,並提供延展性及資料加速。

※探索職場,透視薪資行情,請參考【科技類-職缺百科】幫助你找到最適合的舞台

瀏覽 656 次