AI攻擊普及化?— 論數據濫觴與解方|專家論點【Howie Su】

作者:Howie Su(產業分析師)

人工智慧攻擊更加頻繁,並且經常利用訓練數據

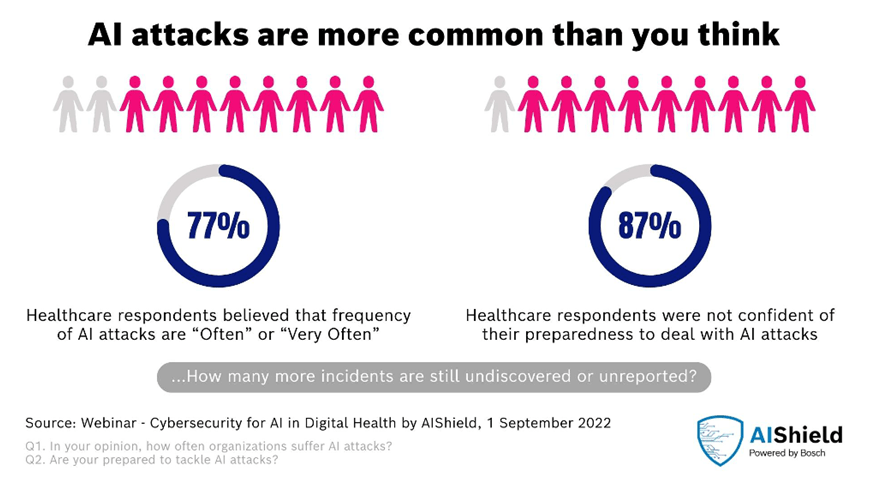

對抗性機器學習早在 2004 年就開始被研究,但在當時,它只被當成一個有趣的題目,而不是安全威脅。不過在過去四年中,微軟發現針對商業機器學習系統的攻擊顯著增加,市場報告也強調了這個問題,Gartner預測“所有人工智慧網路攻擊中的 30% 將利用訓練資料中毒、人工智慧模型盜竊或對抗性樣本來攻擊人工智慧驅動的系統。”儘管有這些令人信服的理由來保護機器學習系統,但微軟對 28 家企業的調查發現,大多數產業從業者尚未接受對抗性機器學習。

對抗性機器學習攻擊會導致多種組織損害和損失—財務、聲譽、安全、智慧財產權、人員資訊和專有資料。在醫療保健、銀行、汽車、電信、公共部門、國防和其他行業,人工智慧的採用因與安全相關的新興攻擊、不符合人工智慧原則、違反監管規定和軟體安全等帶來的安全風險而受到影響,駭客能夠透過各種方式使用對抗模式來繞過人工智慧系統。這可能會對未來的安全系統、工廠機器人和自動駕駛汽車產生重大影響—在所有這些領域,人工智慧識別物體的能力至關重要。

全球各地的機構與政府紛紛提出了法規、最佳實踐和原則來強調人工智慧安全的重要性,這將影響人工智慧安全公司必須建立的能力。舉例而言,歐盟憑藉著世界上第一部全面的人工智慧法《歐盟人工智慧法》走在了前面,《歐盟人工智慧法》目的在確保歐盟人工智慧系統的安全並尊重基本權利和價值觀,它提出一種風險管理的方法,來考慮和補救人工智慧系統對基本權利和用戶安全的影響。根據該法案,高風險人工智慧系統是允許的,但它們的安全性和穩健性非常重要。開發人員和系統所有者必須滿足適當的準確性、穩健性和網路安全性,而人工智慧被視為高風險的領域包括自動駕駛汽車、醫療設備和關鍵基礎設施機械等。

業界正在積極開發人工智慧安全技術

確保人工智慧的安全面臨著獨特的挑戰,這些挑戰與不斷發展的技術環境、專業人才的缺乏以及強大的開源人工智慧安全工具的可用性限制有關,這些限制增加企業客製化資安解決方案的成本,並造成業者對負責任的人工智慧採用和監管合法性的擔憂,使企業面臨人工智慧投資回報 (ROI) 下降的問題。因此,如何開發人工智慧安全技術來強化系統的防禦能力就是企業的下一步,透過自動偵測漏洞來降低潛在攻擊的風險和影響,當然,為了讓人工智慧在資安上發揮更大作用,業者必須:

- 在人工智慧部署過程中識別並解決潛在的攻擊媒介。

- 改進他們的模型開發和部署流程,使攻擊的編排更具挑戰性。

- 針對潛在的人工智慧違規行為制定強而有力的回應策略。

- 有全面的安全平台來保護重要的人工智慧資產,包括基於 SaaS 的 API,用於跨所有部門的人工智慧模型安全評估和威脅防禦,並用於醫療保健、汽車、製造、網路防禦、銀行業和其他領域。

瀏覽 679 次