AI語言模組 尚未在醫療領域贏得一席之地

編譯/高晟鈞

ChatGPT的出現,在全世界颳起了一陣旋風,影響了各大領域的產業鏈。諸如ChatGPT、Google的MedPaLM等基於LLM的聊天生成工具,雖具有巨大的醫療潛力,卻也同時處於法規的灰色地帶,故而存在著使用風險。

Stephan Gilbert教授在Nature Medicine上發表的一篇新論文表示,如何在一般情況下,特別是在健康方面,監控這種大型的語言模型,將是我們這個時代最緊迫的全球性問題。

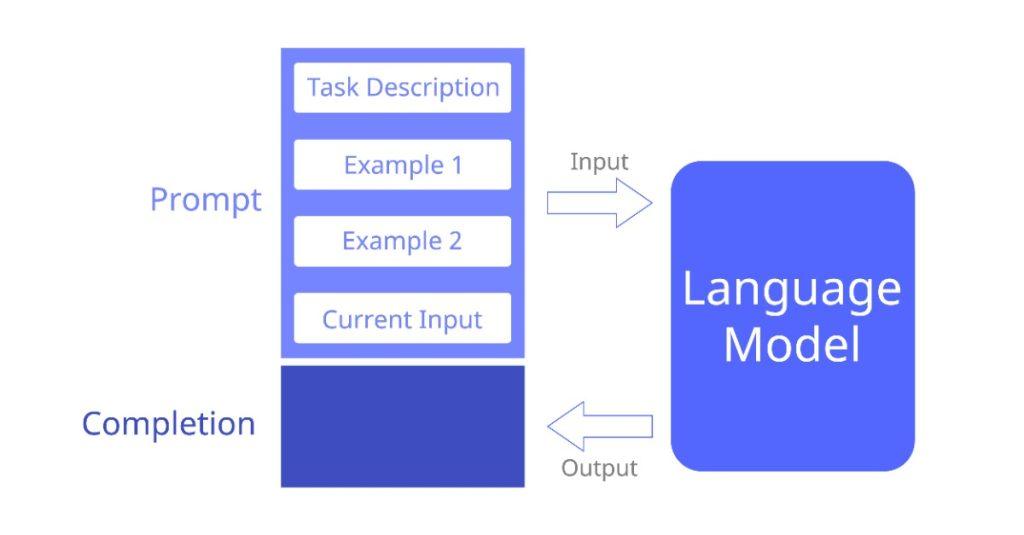

大型語言模組,或稱聊天生成器(LLM)是具有仿人類對話能力的神經網路語言模型。他們會生成類似人類回覆的交互式對話。然而,LLM生成的語句,由於充滿著肯定語氣,因此常常誤導用戶,並導致嚴重的後果。

在醫療方面,即使是同一種疾病,病徵和治療方式也會因為個體的差異,而有所不同。倘若無法確定臨床信息,提供有根據的支持證據,這些聊天機器人將被認為是不安全的工具。因此我們有必要開發新的框架,來保護患者的安全。

相信大多數人在尋求醫生的幫助前,都會上網搜索來對自己的症狀有初步的認識與了解;在此,搜尋引擎便在其中發揮著重要的作用。然而,將聊天機器人集成到搜索引擎當中,可能會因為其具有說服力的語調,增加用戶對於參考答案的信心。事實證明,聊天機器人在應對醫療問題,有時會提出不具有「事實基礎」的回答,而這無疑是十分危險的。

在本文中,作者描述了AI聊天機器人,如何在當前框架下,在各領域,尤其是醫療保健上,贏得一席之地。本文描述了開發人員如何將AI集成到醫療設備中,得到了監管機構的證明和批准的同時,也保障患者的安全。

「目前的聊天機器人仍不符合醫療保健領域人工智能的關鍵原則,例如偏差控制、可解釋性、監督系統、驗證和透明度。為了在醫療設備中贏得一席之地,聊天機器人的設計必須具有更高的準確性、安全性和臨床性。」Gilbert教授總結道。

資料來源:MedicalXpress

瀏覽 1,498 次