大型語言模型不夠!Google再推A3超級電腦狂搶AI市場|專家論點【Howie Su】

作者:Howie Su(產業分析師)

大AI模型還不夠看,還要有大算力支撐

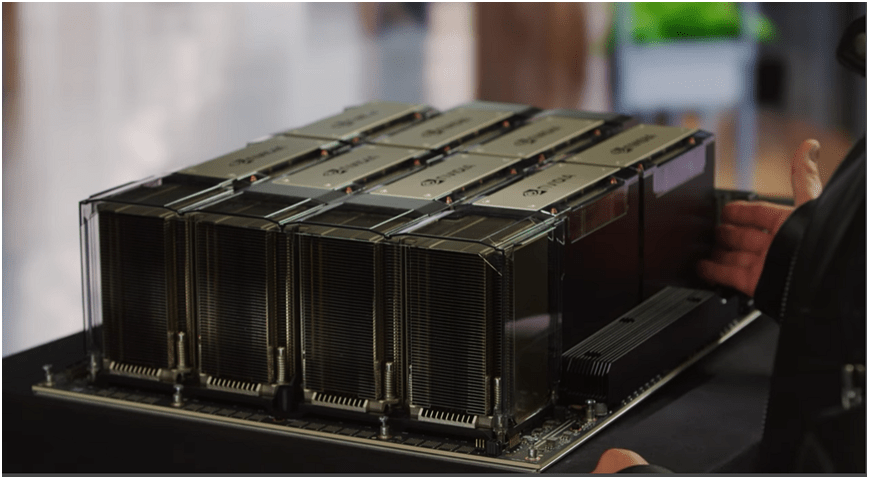

Google的AI打法一波接一波,除了前幾週的開發者(I/O)大會上宣佈推出大型語言模型PaLM2外,近期又推出超級電腦「A3」,打算從AI的模型到算力軍備一次補齊,A3是一種擁有 26,000 個Nvidia H100 Hopper GPU的 AI 超級電腦(世界上最快的超級電腦 Frontier擁有 37,000 個 AMD Instinct 250X GPU),宣告與微軟爭奪 AI 霸權的戰鬥中,Google計畫投入更多資源進行絕地大反攻。A3 超級電腦是對現有 A2 款式與 Nvidia A100 GPU 提供的運算資源的重大升級,公司正在將所有分佈在不同地理位置的 A3 運算實例匯集到一台超級電腦中,該超級電腦的主力客群是希望訓練大型語言模型的企業,當前不少雲端服務業者都在部署 H100 GPU,Nvidia 在 3 月份推出自己的 DGX 雲端服務,除了模型大小,以GPU數量為指標運算能力現在也變成科技業肉搏戰的中心。

A3 是第一個透過名為 Mount Evans 的基礎設施處理單元連接 GPU 實例的虛擬機,該單元由Google和Intel聯合開發,IPU 允許 A3 虛擬機卸載網絡、存儲管理和安全功能,這些功能傳統上是在虛擬 CPU 上完成的,IPU 允許以 200Gbps 的速度傳輸數據,A3 超級電腦將裝備八個 H100 GPU,功能上來說,這些GPU使用Nvidia 專用的交換和晶片技術互連,同時將透過 NVSwitch 和 NVLink 相互連接,其通訊速度約為 3.6TBps,當然,Google死敵微軟的Azure也在 AI 超級電腦上提供相同的速度,並且兩家公司都部署 Nvidia 的電路板設計,可以說在基礎建設上這兩家巨頭都需要NVIDIA的支援,那Google要如何突出?

Google的「超級運算力策略」正在啟動

事實上,GPU 的數量已經成為雲端提供商推廣其 AI 運算服務的重要招牌,微軟在 Azure 中的 AI 超級電腦與 OpenAI 合作,擁有 285,000 個 CPU 內核和 10,000 個 GPU,微軟還宣布配備更多 GPU 在下一代的 AI 超級電腦,Oracle 的雲端服務提供對512 個 GPU,並且正在研究新技術以提高 GPU 通訊的速度;Google持續強調其 TPU v4 人工智慧晶片,這些晶片被運行於帶有大型語言模型的內部人工智慧應用程式,TPU v4從2020年用於Google Cloud,搭載TPUv4的超級電腦提供Exascale等級的ML效能,例如在Google的 Bard 產品,公司的 AI 子公司 DeepMind 指出,TPU正在快速提升 AI 各種應用。

就像Google對 TPU的熱衷一樣,Nvidia 的 GPU 已經成為雲端提供商的必需品,因為客戶正在 CUDA 中編寫 AI 應用程式,這是 Nvidia 專有的編程模型,該軟體工具包基於 H100 的專用 AI 和圖形內核提供的加速生成最快的結果,客戶可以透過 A3超級電腦運行 AI 應用程式,並透過 Vertex AI、Google Kubernetes Engine與Google Compute Engine 服務使用 Google 的 AI 開發和管理服務,公司可以使用 A3 超級電腦上的 GPU 作為一次性租用,結合大型語言模型來執行訓練,然後再將新的資料輸入模型,並在無需從頭開始重新訓練狀況下更新模型,一套完整的流程,就是「超級運算力策略」。

瀏覽 807 次