Meta開源AI模型ImageBind 結合6大感知更像人類

記者/竹二

隨著人工智慧的應用越來越多元,Meta AI近日開源了多模態AI模型ImageBind,整合了6大感知形式,囊括了照片影片、文字、聲音、深度、熱量與慣性測量單元(IMU),可以讓機器能夠像人類一樣,全面分析不同類型的資料,像是用聲音及影像來形成影像,或是以聲音來產生影像的生成能力。

在傳統的AI系統當中,每個模態都會有一個特定的嵌入,ImageBind則建立了不同模態的共同嵌入空間,而且不需要針對各模態之間的不同結合進行訓練。這個進展非常重要,因為人類多半能夠從少數的例子中學到新的概念,像是只是閱讀對動物的文字描述,就得以在現實生活中辨認他們,但是在AI領域中,隨著模態數量的增加,缺乏感官資料會限制標準的模態學習,但分布不同資料的共同嵌入空間,則可讓模型學習不同的模態。

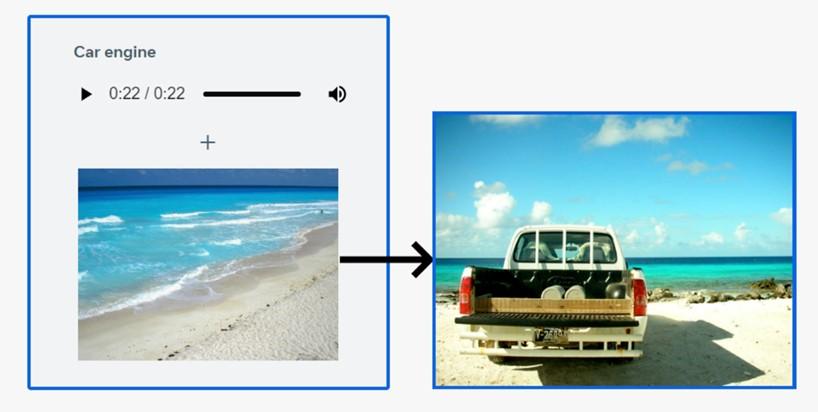

因此,基於共同嵌入空間的ImageBind不僅可以利用影像來汲取聲音、以文字來造就影像與聲音、用聲音及影像來形成影像,像是把海浪的聲音加入海灘的照片中,輸入火車的聲音可以得到相關的影像,輸入狗叫聲再加上海灘照片可以得到狗望向大海的照片。

根據Meta AI的說明,ImageBind展示的是藉由配對的圖像資料,就足以結合這6種不同的模態,讓模型得以更全面解讀內容,現階段的研究中僅使用6種模態,未來若導入更多的模型,像是觸覺、說話、嗅覺等,將會帶來更豐富、更像人類的AI模型。

Meta AI開源了多模態AI模型ImageBind,整合了6大感知形式。(圖/截取自Meta AI)

瀏覽 641 次