AI 技術推波助瀾 語音偽造成詐騙工具

記者/劉閔

電視出現詐騙的新聞總是屢見不鮮,並且手法一直推陳出新,就連國外也是飽受其害。近期從美國聯邦貿易委員會(Federal Trade Commission,FTC)公布 2022 年詐騙數據可發現「冒名詐騙」數量最為盛行,並且在這 5 千多起電話詐騙案件中財損金額就高達 1,100 萬美元;而令人憎恨的是這些電話詐騙的發話者可能藏於世界任何角落,以致很難將之繩之以法。

由於電話詐騙成本低廉,僅需一台電話便可執行,所以成為常見的詐騙手段。另外由於人工智慧技術持續進步,變相也提供詐騙者更好使用的工具。例如在 2019 年時詐騙集團便是利用人工智慧技術,合成仿冒英國能源母公司主管聲音,並向其下屬謊稱供應商需要資金,要求立即匯款,下屬不疑有他進而讓公司損失 20 多萬美元的案例。

而近幾年合成語音詐騙更是層出不窮,並且由於技術發展出現「深度聲音」、和「深度偽造」等令人更難以分辨的形式。這都是透過電腦深度學習技術來獲得人類語言、特徵,之後再製造出能夠以假亂真的相似內容。

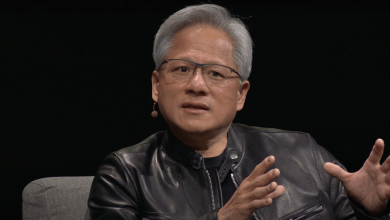

根據外媒報導,來自加州大學的數位鑑識學教授 Hany Farid 表示,兩年前電腦還需要長時間樣本分析,才有辦法將聲音模仿到位;但現在 AI 僅需要短短 30 秒就可以捕捉聲音特徵,包含年齡、性別甚至口音等如此精細地步。

有鑑於此各界總是不斷呼籲,面對突來的或是感覺不安甚至疑惑的電話,第一步仍然需要先保持冷靜,不可貿然輕易相信對方,並且嘗試於通話後主動聯繫當事人,確認事件真偽。唯有如此再三確認,才能免於淪為人工智慧下的犧牲品。

瀏覽 877 次