跳過第三方雲端 Mac、PC也可運行AI模型

編譯/安德烈

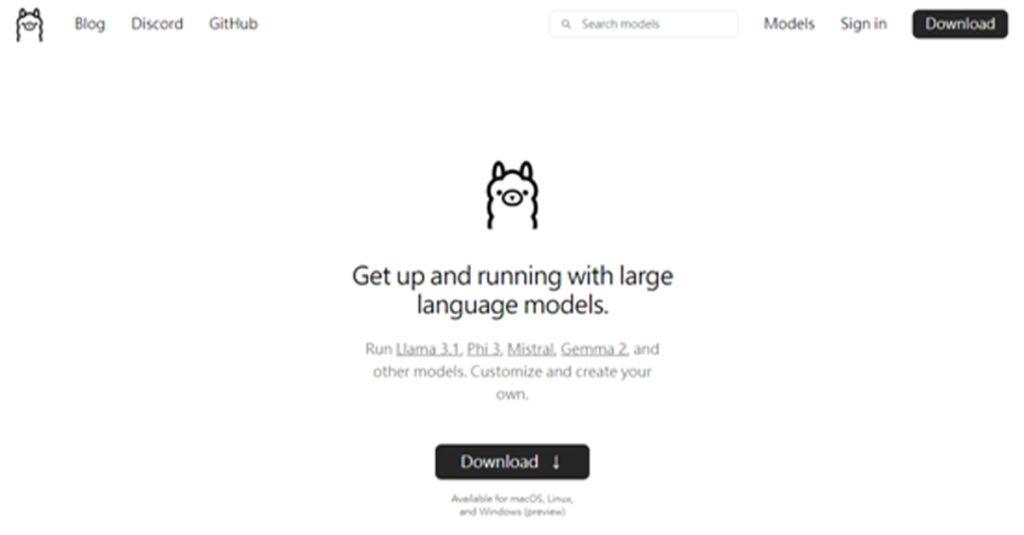

隨著人工智慧(AI)技術的迅速發展,越來越多的開發者,希望在不依賴第三方雲端服務的情況下,在設備內運行如Meta的Llama 3.1等先進模型,為此,Ollama也已經成為幫助開發者和研究人員在自己的硬體上,輕鬆運行和管理機器學習模型的強大開源平台,並能透過其在Mac、Linux和Windows上設置和運行Llama 3.1及私有托管模型。

Ollama簡介

Ollama由一群AI愛好者和工程師開發,旨在提供確保數據隱私、靈活性和控制的工具,該平台支援多種AI模型,為那些希望探索和利用AI技術,而不依賴第三方雲端服務的人提供了一個寶貴的資源。

更多新聞:Meta發布超強新Llama模型 超越GPT-4o和Claude

設置和運行步驟

要在Mac或PC上運行Ollama和Llama 3.1模型,首先要到Ollama的下載頁面,下載並安裝適用於自己設備操作系統的安裝程式,安裝完成後,打開終端或命令提示符,運行「ollama run llama3.1:8b」命令,以加載8B參數的Llama 3.1模型。

為了添加WebUI,用戶也需要安裝Docker Desktop,並運行命令啟動Open WebUI,然後進入Docker儀表板,最後,再使用Continue將Ollama整合到自己的IDE中,這樣就能利用AI驅動的功能,如程式碼建議、自動完成和調試幫助等。

在設備上運行AI的好處

隨著Ollama的出現,開發者和研究人員現在可以在自己的硬體上,運行和管理各種AI模型,而不必依賴第三方雲端服務,不僅提升了數據隱私和靈活性,還為探索和創新提供了更大的空間,無論是使用Ollama在Mac、Linux或Windows上運行Llama 3.1,還是整合強大的GPU進行擴展,這些方法都能幫大家在AI領域中獲得更大的成功。

參考資料:zdnet

瀏覽 789 次