台灣大專院校首座DGX H100/H200伺服器 陽明交大AI高速運算平台啟用

記者鄧君/新竹報導

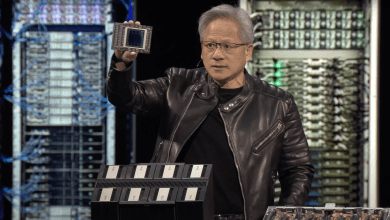

為了強化在AI研究領域的實力,國立陽明交通大學建置一座AI高速運算平台,6日舉辦捐贈儀式暨啟用典禮,成為台灣大專院校首座Nvidia DGX H100/H200伺服器。

陽明交大表示,這個平台包括兩台H100和三台H200伺服器,擁有40片GPU運算卡,算力達1.7 PFLOPS(每秒千兆次浮點運算)。未來可支援校內研究團隊強勁的GPU算力需求,提升陽明交大在AI研究領域的國際競爭力。

陽明交大林奇宏校長表示,為了強化在AI研究領域的實力,學校積極規劃建置一座AI高速運算平台,啟用典禮除了感謝尊博科技(JUMBO)執行董事許順宗學長慷慨捐贈新台幣壹仟萬用於母校購置GPU伺服器。同時也邀請到輝達全球副總裁暨台灣區總經理邱麗孟見證儀式,共同宣示藉由提升學校在GPU高速運算資源的建置,迎向未來AI時代的挑戰,厚植AI研究技術與能量。

陽明交大資訊技術服務中心主任施仁忠表示,此AI高速運算平台已配備兩台DGX H100伺服器,未來半年內將陸續整合三台DGX H200伺服器,並且將引入AI高速平行檔案系統加入陣列,搭配無線頻寬交換機,使總共40片H100/H200 GPU運算卡可叢集使用,增加多張GPU運算卡使用的數量和靈活度。現有平台已搭配資源排程與管理軟體,將可有效率且彈性地提供AI運算資源給各校內研究團隊使用。

電機系簡仁宗教授表示,他的實驗室研究團隊主要在做AI模型訓練,過去需要跑一天的實驗結果,在使用校方最新建置的AI高速運算平台後,只需花兩個多小時即能產生結果,大幅減少實驗的等待時間,並且在四倍多記憶體擴充下訓練出效能更強預測更準之AI模型。此外,主要在研究影像辨識系統設計的電機資訊國際學位學程博士生冉達恩,在使用了平台一個月後,也因為得到足夠的資料,已將結果撰寫成論文,投到國際會議及國際期刊中發表。

陽明交大AI高速運算平台目標在整合和提供校內所需的GPU運算資源,提升全校運算資源建置的效率,並搭配校內綠能機房,電力使用效率(Power Usage Effectiveness,簡稱PUE)可達1.58,將可有效節省能耗、減少碳排,維運團隊將持續朝向資源共享和節能減碳的目標邁進。

陽明交大指出,在現今資安至關重要的時代,保護運算資源亦是一項重要任務,團隊將延續本校資訊中心既有的完善資安防護機制,包含安全遠端存取、防火牆和異常監控等,對AI高速運算平台進行資安防護。

瀏覽 558 次